Sísmica de Reflexión

La sísmica ha contribuido mucho a la sociedad: nos ha ayudado a descubrir y describir recursos de hidrocarburos, acuíferos, anomalías geotérmicas, peligros en el fondo marino y mucho más. El primer descubrimiento con sísmica no se produjo hasta varios años después, 1921 fue el año en que se inventó el método de reflexión sísmica.

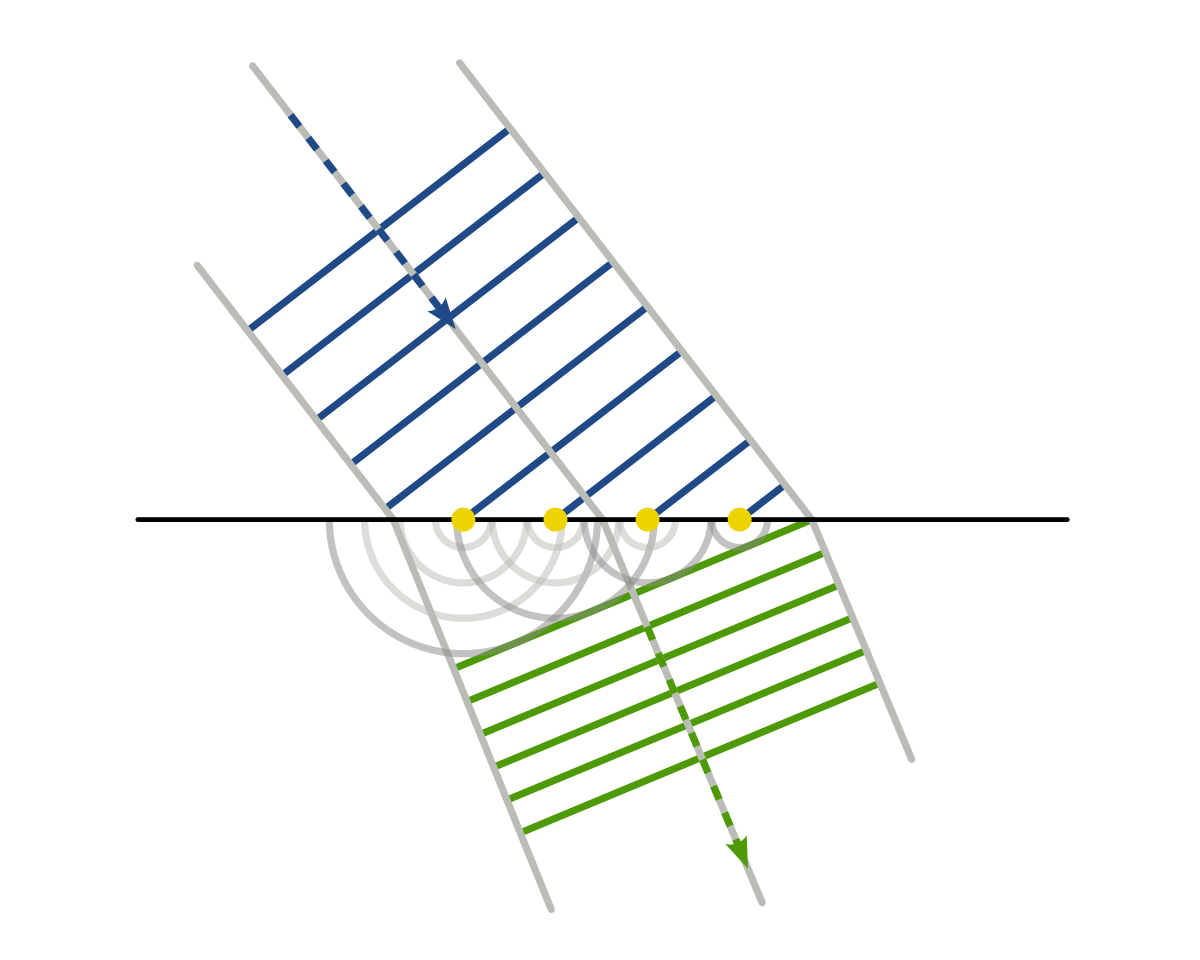

|

| Figura 1. Esquema referente a la exploración sísmica de reflexión, donde se pueden visualizar los principales fenómenos que ocurren durante la adquisición. Fuente: Gustavo, M.(2018) [1] |

Primeros avances (Finales del siglo XVII - Principios del siglo XX)

1600: Pierre de Fermat, un matemático francés, formuló el principio de Fermat, que establece que la trayectoria tomada por la luz (o una onda en general) entre dos puntos es aquella que toma el menor tiempo posible. En la sísmica, este principio se aplica para predecir la trayectoria de las ondas sísmicas a través de diferentes capas geológicas. La aplicación del principio de Fermat en la sísmica de reflexión ayuda a determinar cómo las ondas viajan a través de medios con diferentes velocidades sísmicas, lo que es fundamental para la migración de datos y la interpretación de reflexiones complejas.

| Figura 2. Pricipio de Fermat: la luz sigue la trayectoria de menor tiempo. |

1678: Hooke R. (1678) [2], un científico británico, formuló la Ley de Hooke, que describe el comportamiento elástico de los materiales. La ley establece que la deformación de un material es proporcional a la fuerza aplicada, hasta el límite elástico del material. En la sísmica de reflexión, la Ley de Hooke es fundamental para entender cómo las ondas sísmicas se propagan a través de la Tierra. Las ondas sísmicas generan esfuerzos y deformaciones en las rocas, y el comportamiento elástico de las rocas, descrito por la Ley de Hooke, determina la velocidad y el comportamiento de las ondas de compresión (ondas P) y las ondas de corte (ondas S). Esta ley es esencial para modelar cómo las ondas viajan a través de diferentes tipos de roca y para la interpretación de datos sísmicos.

|

| Figura 3. La ley de Hooke indica que la deformación unitaria de un cuerpo elástico es proporcional a la fuerza que se le aplica. |

1690: Huygens C. (1962) [3], un físico y matemático holandés, propuso el principio de Huygens, que establece que cada punto en un frente de onda puede ser considerado como una fuente de ondas secundarias que se propagan hacia afuera en todas las direcciones. Este principio es fundamental para entender cómo las ondas se propagan a través de medios inhomogéneos y cómo se forman las ondas reflejadas y refractadas en la sísmica. En el contexto de la sísmica de reflexión, el principio de Huygens es esencial para explicar cómo las ondas sísmicas interactúan con interfaces geológicas y cómo se generan las reflexiones que se registran en la superficie. Las reflexiones sísmicas son el resultado de la superposición constructiva de estas ondas secundarias en las interfaces entre capas con diferentes propiedades físicas.

|

| Figura 4. Principio de Fresnel-Huygens. Todo punto de un frente de onda inicial puede considerarse como una fuente de ondas esféricas secundarias que se extienden en todas las direcciones con la misma velocidad, frecuencia y longitud de onda que el frente de onda del que proceden. |

1807: Jean-Baptiste Joseph Fourier (1955) [4], un matemático francés, desarrolló la transformada de Fourier a principios del siglo XIX. Esta transformada es una herramienta matemática que descompone una función en sus componentes de frecuencia, convirtiendo una señal del dominio del tiempo al dominio de la frecuencia. En la sísmica de reflexión, la transformada de Fourier es fundamental para el procesamiento de señales. Permite analizar la frecuencia de las ondas sísmicas y filtrar el ruido, mejorando la claridad de las imágenes sísmicas. También es crucial en la migración de datos y en la inversión sísmica, donde se utilizan componentes de frecuencia para reconstruir la imagen del subsuelo.

|

| Figura 5. Principio de Fresnel-Huygens. Es una transformación matemática empleada para transformar señales entre el dominio del tiempo (o espacial) y el dominio de la frecuencia, que tiene muchas aplicaciones en la física y la ingeniería. |

1820: Augustin-Jean Fresnel, un físico francés, desarrolla la teoría de la difracción, que establece cómo las ondas (incluidas las ondas sísmicas) se propagan y se ven afectadas por los obstáculos en su camino. Aunque Fresnel trabajó principalmente con luz, sus teorías sobre la propagación de ondas sentaron las bases para comprender cómo las ondas sísmicas interactúan con las diferentes capas de la Tierra.

1827: Augustus Edward Hough Love formula la teoría matemática de las ondas elásticas en sólidos, conocidas hoy como ondas de Love, que son un tipo de onda superficial sísmica. Este trabajo es fundamental para la comprensión del comportamiento de las ondas elásticas, que son cruciales en la sísmica de reflexión.

|

| Figura 6. Comportamiento de la onda Love. |

1885: Lord Rayleigh (John William Strutt) (1945) [5], otro físico británico, describe las ondas de Rayleigh, un tipo de onda superficial que también se mueve a través de la corteza terrestre. Las ondas de Rayleigh, junto con las ondas de cuerpo (ondas P y S), forman parte del conjunto de ondas sísmicas que se utilizan en la exploración sísmica.

|

| Figura 7. Comportamiento de la onda Rayleigh. |

1909: Andrija Mohorovičić, un geofísico croata, descubre la discontinuidad de Mohorovičić (Moho), la cual es la frontera entre la corteza terrestre y el manto. Mohorovičić utilizó el análisis de las ondas sísmicas generadas por un terremoto para identificar la diferencia en la velocidad de las ondas a través de diferentes capas de la Tierra, lo que le permitió inferir la existencia de una discontinuidad. Este hallazgo es un precursor clave para la sísmica de reflexión, que se basa en la identificación de fronteras entre diferentes capas geológicas.

1914: Albert Michelson y Francis Pease aplican principios de interferometría para medir la deformación de la corteza terrestre. Aunque este trabajo no está directamente relacionado con la sísmica de reflexión, influye en el desarrollo de técnicas para medir y analizar la propagación de ondas elásticas a través de la Tierra.

1919: Ludger Mintrop, un geofísico alemán, utiliza el geófono, un dispositivo que él mismo desarrolló, para detectar y registrar ondas sísmicas en experimentos de refracción. Aunque sus primeros trabajos se centraron en la sísmica de refracción, estos desarrollos tecnológicos serían fundamentales para la posterior implementación de la sísmica de reflexión.

1921: Se realiza el primer experimento exitoso de sísmica de reflexión en Oklahoma, Estados Unidos, llevado a cabo por la Compañía de Exploración Geofísica de Tulsa (más tarde conocida como Seismos), llevado a cabo por Clarence Karcher, William Haseman, Irving Perrine, William Kite y Daniel Ohern. Este experimento es considerado el primer uso práctico de la sísmica de reflexión, demostrando que es posible utilizar ondas sísmicas para mapear las estructuras del subsuelo. Este experimento, aunque rudimentario en comparación con los estándares modernos, marca el nacimiento de la sísmica de reflexión como herramienta para la exploración de hidrocarburos.

|

| Figura 8. Tomado de la patente de Karcher, «Determinación de las formaciones del subsuelo». Ilustra las llegadas de distintos modos de onda a los receptores. Fuente: Hall M. (2001) [7]. |

- 1919: Karcher grabó el primer registro sísmico de reflexión con fines de exploración cerca de la Oficina Nacional de Estándares (ahora NIST) en Washington, DC.

- Abril de 1921: Karcher, mientras trabajaba en la Oficina Nacional de Estándares (ahora NIST) de Washington, DC, diseñó y construyó aparatos para registrar las reflexiones sísmicas.

- 4 de Junio de 1921: Las primeras pruebas de campo del sismógrafo de reflexión en Belle Isle, Oklahoma City, utilizando una fuente de dinamita. Se hicieron varias pruebas a diferentes distancias entre fuentes y receptoras (Offset).

- 14 de julio de 1921: Pruebas en las montañas Arbuckle. El equipo de Karcher, Haseman, Ohern y Perrine determina las velocidades de la caliza Hunton, el esquisto Sylvan y la caliza Viola.

- Agosto de 1921: El grupo se desplaza a Vines Branch, donde «se midió la primera sección geológica sismográfica de reflexión del mundo», según una placa conmemorativa en la I-35 de Oklahoma. Se registra la profundidad de la caliza Viola y se observa que cambia con la estructura geológica.

|

| Figura 9. Primera sección geológica sismográfica de reflexión del mundo, en Vines Branch, Ohklahoma. Fuente: Hall M. (2001) [7]. |

- 1925: Karcher creó una nueva empresa -Geophysical Research Corporation, GRC, ahora parte de Sercel- con Everette Lee DeGolyer, de Amerada Petroleum Corporation, y dinero del vizconde Cowdray (propietario de Pearson, ahora una editorial, pero originalmente una empresa de construcción).

Gracias a esta empresa, Karcher acabó imponiéndose en la carrera por probar el método de reflexión sísmica. Por lo que se sabe, HB Peacock cartografiaron con éxito la estructura de la caliza ordovícica Viola. El 4 de diciembre de 1928, Amerada terminó el pozo Hallum nº 1 cerca de Maud, Oklahoma, el primer descubrimiento de petróleo perforado con datos de reflexión sísmica.

|

| Figura 10. Las ubicaciones de la primera prueba de sismología de reflexión, la primera sección sísmica y el primer estudio sísmico que condujo a un descubrimiento. El mapa también muestra dónde creció Karcher; fue a la universidad en Norman, al sur de la Ciudad de Ohlahoma. Fuente: Hall M. (2001) [7]. |

1927: Reginald Fessenden, un inventor canadiense, realiza algunos de los primeros experimentos de sísmica de reflexión en ambientes marinos. Fessenden utiliza un generador de ondas sonoras y detectores para mapear el fondo del océano. Su trabajo representa una de las primeras aplicaciones de la sísmica de reflexión en la exploración submarina.

1928: Harry Nyquist, un ingeniero sueco-estadounidense, formuló el teorema de muestreo de Nyquist en 1928. Este teorema establece que para reconstruir completamente una señal a partir de sus muestras, la tasa de muestreo debe ser al menos el doble de la frecuencia más alta presente en la señal. En la adquisición de datos sísmicos, el teorema de Nyquist es crucial para garantizar que los datos se muestrean a una tasa adecuada para evitar el aliasing, un fenómeno en el que las frecuencias superiores a la mitad de la tasa de muestreo se pliegan en frecuencias más bajas, distorsionando la imagen sísmica.

![A [Mathematical] Analysis of Sample Rates and Audio Quality – Techbytes](https://websites.umass.edu/Techbytes/files/2018/03/loc_eps_aliasing_effects.gif) |

| Figura 11. Teorema del muestreo de Nyquist. A mayor nivel de muestras, la señal original podrá ser replicada. |

1930: Stephen Butterworth desarrolla el filtro Butterworth, conocido por su respuesta en frecuencia "plana", sin ondulaciones en la banda de paso. Aunque inicialmente diseñado como un filtro analógico, sus principios fueron adaptados posteriormente para los filtros digitales.

1930s:

Durante esta década, se desarrollan los primeros fundamentos teóricos

formales para la sísmica de reflexión. Los geofísicos comienzan a

entender que las ondas sísmicas, cuando encuentran una discontinuidad

entre capas de diferentes densidades o velocidades, se reflejan y

refractan según las leyes de Snell. Las leyes de Snell, que describen cómo se refractan las ondas en la interfaz entre dos medios, son fundamentales para la interpretación sísmica.

1930s: La Compañía de Exploración Geofísica de Tulsa sigue desarrollando y perfeccionando la técnica. A lo largo de esta década, la sísmica de reflexión se convierte en una herramienta estándar en la exploración petrolera en Estados Unidos y Europa.

1936: Herman W. Kallenberg, trabajando para Shell Oil Company, hace avances significativos en la adquisición y procesamiento de datos sísmicos, ayudando a mejorar la calidad de las imágenes reflejadas.

1940s: La Segunda Guerra Mundial impulsa avances significativos en electrónica y procesamiento de señales, tecnologías que luego serían aplicadas en la sísmica de reflexión. En esta época, se desarrollan registradores sísmicos más precisos y se comienza a utilizar la sísmica de alta resolución para identificar estructuras geológicas más complejas.

1932: El principio de superposición es un concepto fundamental en la física de ondas que establece que cuando dos o más ondas se encuentran en un punto, la onda resultante es la suma algebraica de las ondas individuales. Este principio es aplicable tanto a ondas constructivas como destructivas. En la sísmica de reflexión, el principio de superposición se aplica en la formación de ondas complejas cuando múltiples reflexiones y refracciones interactúan. Esto es importante en el procesamiento de señales, donde se deben separar las señales útiles de las interferencias y el ruido.

| Figura 12. Representación del principio de superposición de ondas |

1946: Dennis Gabor (1946) [8], un físico húngaro-británico, introdujo el análisis de Gabor, que es una técnica para analizar señales en el dominio tiempo-frecuencia, utilizando ventanas de análisis de tiempo limitado. Esto permite estudiar cómo las frecuencias de una señal varían a lo largo del tiempo.En la sísmica de reflexión, el análisis de Gabor es utilizado en la análisis espectral para estudiar la evolución temporal de las frecuencias sísmicas, lo cual es útil para mejorar la resolución temporal de los datos sísmicos y para la detección de variaciones sutiles en la litología del subsuelo.

| Figura 13. Visualización de un horizonte sísmico con el atributo sísmico de la transformada contínua de la ondícula (CWT, por sus siglas en inglés), en donde se utiliza el análisis de Gabor para la creación de mapas de frecuencias dominantes específicas, en este caso (10, 20 y 60 Hz). |

1949: En México, Pemex realiza sus primeros estudios de sísmica de reflexión, aplicando los principios físicos desarrollados anteriormente. Estos estudios son pioneros en el uso de la sísmica de reflexión en la exploración de hidrocarburos en México.

1949: El filtro de Wiener, Desarrollado por Norbert Wiener, este filtro es una técnica adaptativa que minimiza el error cuadrático medio entre la señal filtrada y la señal deseada. En la sísmica, se utiliza para mejorar la relación señal-ruido en los datos.

1950: W. Harry Mayne, inventor del método de reflexión del punto común , para evitar el "aglomeramiento" de los datos sísmicos registrados provocado por el uso de matrices de sensores de geófonos, necesitaba una matriz muy larga para atenuar el ruido, pero cada punto de la matriz debía representar el mismo punto de reflexión del subsuelo.

|

| Figura 14. Ejemplificación del punto medio común (CMP por sus siglas en inglés) |

Era digital y avances tecnológicos (1950s - 1970s)

1960: Rudolf E. Kálmán introduce el Filtro de Kalman, que es un algoritmo recursivo utilizado para estimar el estado de un proceso dinámico a partir de una serie de mediciones ruidosas. Es uno de los primeros filtros que encuentra aplicaciones en procesamiento de señales digitales.

1965: James Cooley y John Tukey desarrollan el algoritmo de Transformada Rápida de Fourier (FFT), que permite el procesamiento eficiente de señales digitales, haciendo factible el diseño y aplicación de filtros digitales en tiempo real.

1970: Filtros FIR (Finite Impulse Response), se desarrollan durante la década de 1960. Son estables y tienen una respuesta de fase lineal, lo que los hace ideales para aplicaciones donde la preservación de la forma de onda es crucial, como en la sísmica de reflexión.

1970s: En la sísmica de reflexión, Ender Robinson, utilizó a la desconvolución para filtrar y que se utiliza para eliminar los efectos de la fuente sísmica y la respuesta del sistema de grabación, mejorando la resolución temporal de los datos sísmicos. Esta técnica se basa en la teoría de filtros y es un avance crucial en el procesamiento de datos sísmicos.

1960s: Con la introducción de la migración sísmica, los geofísicos pueden corregir las distorsiones causadas por la geometría compleja de las capas del subsuelo. La migración es esencialmente un proceso matemático que ajusta la posición de los reflectores sísmicos, permitiendo obtener una imagen más precisa del subsuelo.

- Según Yilmaz Ö. (2001) [9] La migración de datos sísmicos consiste en corregir el supuesto de capas geológicas planas mediante una convolución espacial numérica de los datos sísmicos basada en cuadrículas para tener en cuenta los eventos de buzamiento (cuando las capas geológicas no son planas). Existen muchos métodos, como la popular migración Kirchhoff, pero en general se acepta que el procesamiento de grandes secciones espaciales (aperturas) de los datos a la vez introduce menos errores, y que la migración en profundidad es muy superior a la migración en tiempo con grandes buzamientos y con cuerpos salinos complejos.

- Migración temporal

- La migración temporal se aplica a los datos sísmicos en coordenadas temporales. Este tipo de migración parte de la suposición de que sólo se producen ligeras variaciones laterales de velocidad, lo que se rompe en presencia de la mayoría de las estructuras interesantes y complejas del subsuelo, especialmente la sal.[6] Algunos de los algoritmos de migración temporal más utilizados son: Migración Stolt, Gazdag y Migración por diferencias finitas.

- Migración en profundidad

- La migración en profundidad se aplica a datos sísmicos en coordenadas de profundidad (cartesianas regulares), que deben calcularse a partir de datos sísmicos en coordenadas temporales. Por lo tanto, este método requiere un modelo de velocidad, por lo que requiere muchos recursos, ya que la construcción de un modelo de velocidad sísmica es un proceso largo e iterativo. La gran ventaja de este método de migración es que puede utilizarse con éxito en zonas con variaciones laterales de velocidad, que suelen ser las más interesantes para los geólogos del petróleo. Algunos de los algoritmos de migración en profundidad más utilizados son la migración en profundidad Kirchhoff, la migración en tiempo inverso (RTM), la migración de haz gaussiano y la migración de ecuación de onda.

1970s: Se desarrollan los primeros experimentos de sísmica 3D, liderados por compañías como Exxon y Shell. Estos experimentos demuestran que la obtención de datos tridimensionales permite una visualización más detallada de las estructuras geológicas, lo que facilita la identificación de yacimientos de petróleo y gas. La sísmica 3D emerge como una tecnología revolucionaria. La diferencia clave entre la sísmica 2D y 3D radica en la densidad de los datos adquiridos y la capacidad de crear imágenes tridimensionales del subsuelo, lo que mejora la precisión en la identificación de estructuras geológicas. La sísmica 3D se basa en la adquisición de datos en una red tridimensional, lo que permite un muestreo más completo y detallado de las ondas reflejadas.

|

| Figura 15. Visualización de un modelo de adquisición de sísmica 3D. |

Avances modernos y aplicaciones (1980s - presente)

1980s: La sísmica 3D se convierte en un estándar de la industria petrolera. Los avances en computación y almacenamiento de datos permiten procesar grandes volúmenes de información, generando imágenes tridimensionales detalladas del subsuelo. Compañías como Western Geophysical y Gulf Oil lideran la implementación de esta tecnología.

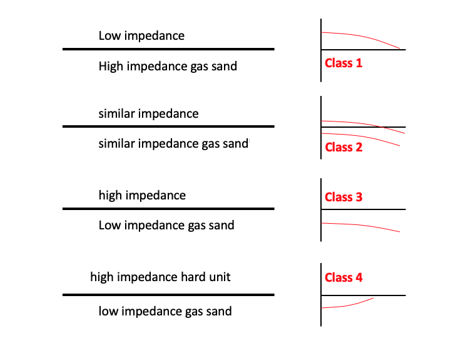

1980s-1990s: Chevron y BP introducen el AVO (Amplitude Versus Offset), que analiza cómo la amplitud de las ondas reflejadas varía con el ángulo de incidencia para predecir las propiedades de los fluidos en los reservorios. Al mismo tiempo, se desarrollan los atributos sísmicos, que proporcionan información adicional sobre la litología y la saturación de fluidos a partir de los datos sísmicos.

|

| Figura 16. Distintas clases de la evaluación AVO. |

1990s: Se introduce la sísmica 4D (o sísmica de monitorización del tiempo), que añade la dimensión temporal al análisis. Esto permite monitorear cómo cambian las propiedades del subsuelo con el tiempo, lo que es especialmente útil para la gestión de yacimientos de petróleo y gas.

2000s en adelante: La industria sigue mejorando las técnicas de procesamiento de datos, desarrollando métodos como la sísmica por inversión de onda completa (FWI, por sus siglas en inglés). Estas técnicas permiten obtener una caracterización más precisa de las propiedades físicas del subsuelo, mejorando la interpretación de los datos sísmicos.

2010s: Los filtros adaptativos se desarrollaron con el avance de las computadoras, los cuáles ajustan automáticamente los coeficientes del filtro en función de las características cambiantes de la señal. Esto es especialmente útil en la sísmica, donde las condiciones de ruido pueden variar significativamente.

La inteligencia artificial y la sísmica de reflexión en la actualidad.

En los últimos años, Machine Learning (ML) y la Inteligencia Artificial (IA) han revolucionado la sísmica de reflexión, mejorando significativamente el procesamiento, interpretación y análisis de datos sísmicos. Inicialmente, en la década de 2000, se introdujeron algoritmos como las Support Vector Machines (SVM) y redes neuronales para la clasificación automática de datos sísmicos y la detección de eventos sísmicos, sentando las bases para aplicaciones más avanzadas.

| Figura 17. Visualización de un horizonte sísmico con el atributo sísmico de Ant Tracking, el cuál se basa en el comportamiento de las hormigas en la colonia, donde se utiliza un algoritmo de optimización. Como el algoritmo no tiene un sentido "geológico", marca todas las discordancias respecto al atributo de similaridad. |

| Figura 18. Visualización de un horizonte sísmico con el atributo sísmico de detección de fallas por CNN, donde se utilizó un modelo de redes neuronales entrenado con imágenes de fallas y fracturas previamente interpretados. |

En la década de 2010, las Redes Neuronales Convolucionales (CNNs) permitieron la detección automática de fallas y horizontes sísmicos, y se empezaron a aplicar Redes Neuronales Recurrentes (RNNs) y LSTM para mejorar la desconvolución y filtrado adaptativo en el procesamiento sísmico. Además, la migración sísmica se benefició del aprendizaje profundo, acelerando los procesos y mejorando la precisión de las imágenes sísmicas.

Las aplicaciones de ML también han mejorado la interpretación sísmica, con el uso de Redes Generativas Antagónicas (GANs) para simular datos y predecir la litología y los fluidos del subsuelo, y la implementación de IA para la interpretación en tiempo real durante la adquisición de datos sísmicos. En la inversión sísmica, los algoritmos de Deep Learning han permitido obtener modelos más precisos y detallados del subsuelo, optimizando la caracterización de reservorios.

Finalmente, la integración de Big Data y AI ha llevado a una mayor automatización y eficiencia en todo el flujo de trabajo sísmico, desde la adquisición hasta el modelado. Estas tecnologías continúan evolucionando, prometiendo un futuro donde AI juegue un papel aún más crucial en la exploración y producción de hidrocarburos, mejorando la precisión y rapidez en la toma de decisiones geológicas.

Exploración y explotación petrolera en México

|

| Figura 19. Mapa de las cuencas petroleras de México. |

Origenes y Desarrollo Temprano

|

| Figura 20. Logo de PEMEX (1938). |

Crecimiento y Nacionalización

|

| Figura 21. Flujo de petróleo descotrolado del pozo Cerro Azul 4. |

|

| Figura 22. Foto de Rudensindo Cantarell, pescador que descubrió emanaciones naturales de hidrocarburo en el Golfo de México, frente a las costas de Ciudad del Carmen. |

Era Moderna

1976: Pozo Cantarell, Descubierto en 1976, fue uno de los mayores yacimientos petroleros en el mundo. Su producción alcanzó un pico de 2.1 millones de barriles por día en 2004, representando aproximadamente el 63% de la producción total de México en ese año.

|

| Figura 23. Ejemplo de tecnología sísmica 4D: imágenes sísmicas de lapsos de tiempo de la pluma de CO 2 de Sleipner. (arriba) perfil sísmico a lo largo de una línea y (abajo) vista en planta de la amplitud sísmica en el campo (Chadwick et al. (2010)). |

Reformas y Actualidad

Conclusión

Bibliografía

[1] Gustavo, M. V. J. (2018). Evaluación del efecto de diferentes modelos de atenuación en la migración preapilado en profundidad utilizando las ecuaciones de sentido único. http:// repositoriodspace.unipamplona.edu.co/jspui/handle/20.500.12744/2975Publicación realizada por Hugo Olea y Kevin García

Contactos:

LinkedIn - Hugo Olea y Kevin García

Correo - hugoolea03@gmail.com y kevingarciasce@gmail.com

No hay comentarios.:

Publicar un comentario